OpenSCHUFA: Verbrauchergerechtes Scoring

Heute findet die Präsentation des Sachverständigenrates für Verbraucherfragen statt. Thema: Faires Scoring. Wir berichten live vor Ort. #fairesscoring #openschufa

Das wichtigste in Kürze

Programm der Veranstaltung Übersichtsseite zu „Verbrauchergerechtes Scoring“ (Sachverständigenrat) Technische und rechtliche Betrachtungen algorithmischer Entscheidungsverfahren (Gesellschaft für Informatik e. V.)

Handlungsempfehlungen

Handlungsempfehlungen des Rats (S. 142-151)

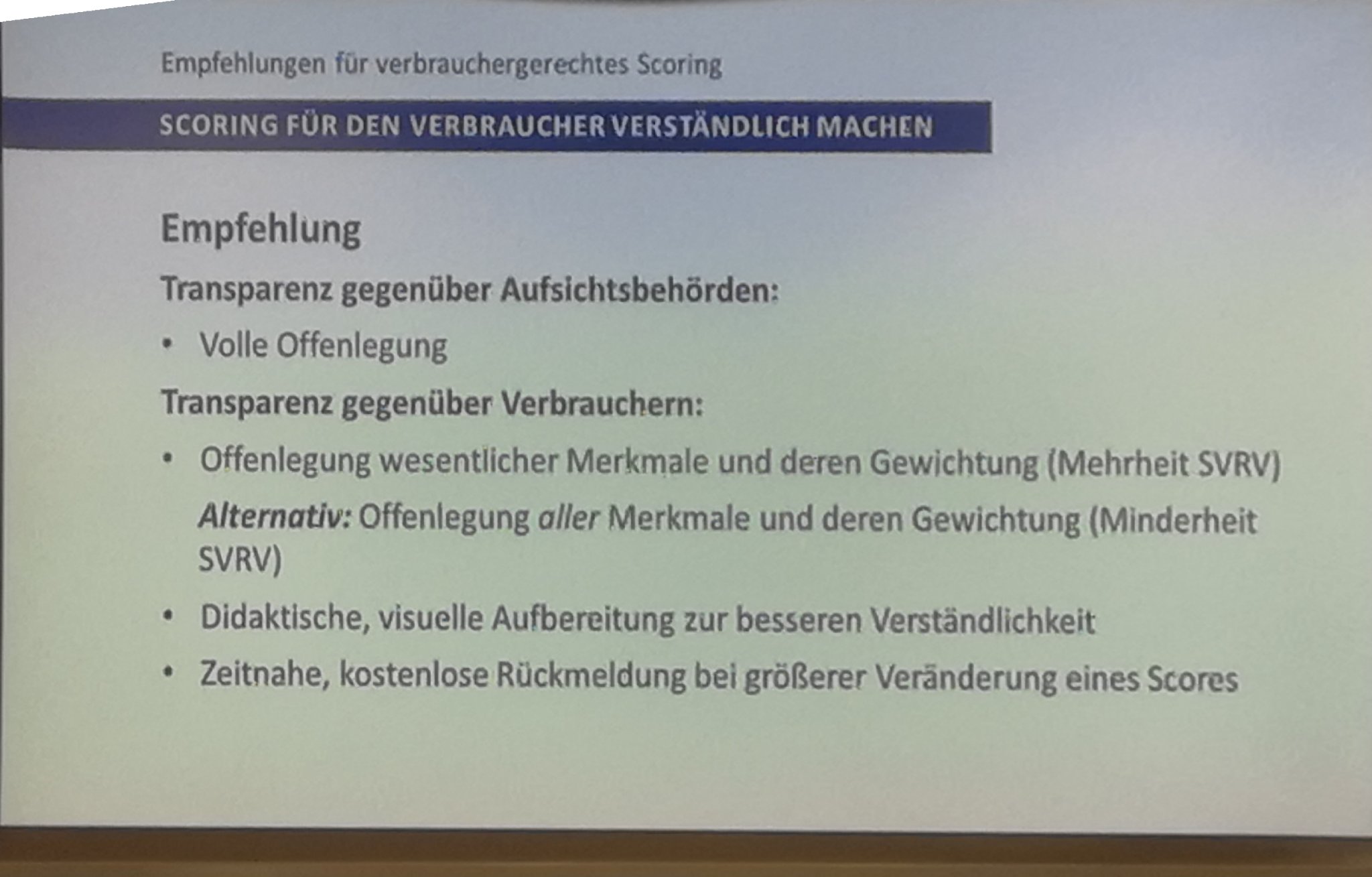

- Scoring für den Verbraucher verständlich machen

- Scoring-Wissen und Kompetenz fördern

- Diskriminierung prüfen und offenlegen

- telematikfreie Option sicherstellen

- Score-Qualität gewährleisten

- Datenqualität sichern

- Aufsicht verbessern

- Super-Scores

Aus den Handlungsempfehlungen:

„Das Potenzial digitalen Scorings kann nur ausgeschöpft werden, wenn eine Reihe von gesellschaftlich legitimen Erwartungen erfüllt sind. Nur dann wird es von Verbrauchern akzeptiert werden und ihnen zunutze sein.“

Das war unser Antrieb für OpenSchufa.

Scoring verständlicher machen

Die ergebnisse der repräsentativen Bevölkerungsbe fragung zeigen im detail, dass das Wissen über die ver wendeten merkmale im Bereich des Bonitätsscorings neben dem alter davon abhängt, ob eine person in den vergangenen fünf Jahren eine Selbstauskunft eingeholt hat. formale Bildung für sich genommen scheint dage gen keinen relevanten Einfluss auf das Scoring- Wissen zu haben. Interessant ist auch, dass die Befragten mehrheitlich dagegen sind, eine Rückmeldung zu ihrem Score-Wert zu erhalten; knapp die Hälfte möchte grund sätzlich (mit unterschiedlicher Häufigkeit) darüber aktiv informiert werden.

Fast 50% der Bevölkerung wünscht sich einen transparenteren Umgang.

Festzustellen, welche Merkmale für Verbraucher wesentlich sind, kann nicht nur Aufgabe des Gesetzgebers sein, sondern sollte auch Aufgabe von Verbraucherorganisationen oder der „Marktwächter“ der Verbraucherzentralen sein. Eine vollständige Offenlegung der Scores und ihrer Eigenschaften gegenüber Aufsichtsbehörden ist in jedem Fall notwendig (vgl. das SVRV Gutachten “Digitale Souveränität).

Dieser Forderung schließen wir uns an.

Ein Teil des SVRV spricht sich für eine weiterreichende Scoring-Transparenz aus. Er ist der Auffassung, dass stets sämtliche in einen Score eingehenden Merkmale gegenüber dem Verbraucher offenzulegen sind und ihr relatives Gewicht in der Score-Berechnung anzugeben ist. Etwaige Geheimhaltungsinteressen der Scoring-Anbieter und -Nutzer haben insoweit gegenüber dem Auskunftsinteresse der Verbraucher zurückzustehen, wobei das Geschäftsgeheimnis der Entwicklung und Programmierung eines scores gewahrt bleiben sollte.

Wir begrüßen, dass ein Teil des Rats eine weitergehende Lösung befürwortet.

Die Verständlichkeit der Scores durch Verbraucher sollte nicht nur von Fachleuten behauptet, sondern empirisch überprüft werden.

###Datenqualität sichern

Eine angemessene Datenqualität bei der Score-Entwicklung ist zu gewährleisten und den Aufsichtsbehörden zu dokumentieren.

Begrüßenswert und wünschenswert. Aktuell gibt es ja noch viel “room for improvement.” Siehe Fall (golem).

3. In der anwendung der Verfahren ist die Korrektheit, Vollständigkeit und aktualität der Daten sicherzustellen.

Sowie der Verlauf der Daten (Hinweis auf ACM, GI Gutachten).

4. Zur Überprüfung der Datenbasis durch die Verbraucher selbst hat der SVRV bereits in seinem Gutachten „Digitale Souveränität“ die Option eines Daten-Dashboards skizziert, um ein verbraucherzentriertes Datenmanagement zu ermöglichen.

Dazu bedarf es der Möglichkeit für den Verbraucher die Daten zu bekommen. Dies ist im Moment nicht der Fall.

Es sei der Hinweis gestattet, die aktuelle Handlungsverbesserungen sind auch ohne Blockchain möglich.

Es freut uns, dass die Vorschläge von “Digitale Souveränität”, die Stärkung der Verbraucherposition übernommen wurde.

Aussagen

Girgenzer

Schufa legt Verfahren den Datenschutzbehörden vor, die Aussage

“Schufaverfahren bereits für Behörden transparent (Hessen)."

Sprecher NRW: Es fehlt notwendiges Fachwissen. Es wird nur auf Plausibilität geprüft.

Hinweis aus Bayern: Gutachten von Auskunftsdateien selbst. Interessenskonflikt.

Gigerenzer vergleicht den Interessenskonflikt der Auskunftsdateien mit Ratingsagenturen vor der Finanzkrise.

Axiom Daten über 44 Mio. Deutsche. Oracle, Deutsche Post auch dabei.

Bzgl. “Super-Scoring” und China der Hinweis auf „Bedenken second“ schiefgehen könnte, falls das Ergebnis nicht gewünscht ist (Fehlerquote Überwachungskameras Südbahnhof).

Frage, welche Gesellschaft wir haben wollen, verbrauchergerechtes Scoring der Weg dort hin.”

Marit Hansen

“mehr Gestaltung an System, dass sie sich besser erklären,

Geht in die nächste Runde. Gibt ja auch die Datenschutzethikkommission."

Wagner

“Für volle Transparenz sind Hr. Girgenzer und ich.” Transparenzschnittstelle, sind ja nur logistische Regression.

Fordert nochmals volle Transparenz, verweist auf FAZ-Artikel wo er die Transparenz-Schnittstelle für

den Verbraucher erklärt.

FAZ

“Ich will wissen was hinten rauskommt”

Hansen

“Borges Wünsche bereits durch Art. 25 erfüllt”

Wolfgang Schulz, @hiig_berlin, betont #Transparenz als Voraussetzung für Behörden und Verbraucher, um Entscheidungsprozesse zu verstehen und bei Bedarf Entscheidungen in Frage zu stellen. #SVRV

Wolfgang Schulz, @hiig_berlin, betont #Transparenz als Voraussetzung für Behörden und Verbraucher, um Entscheidungsprozesse zu verstehen und bei Bedarf Entscheidungen in Frage zu stellen. #SVRV @BMJV_Bund #Scoring

— Sven Scharioth (@scharioth) October 31, 2018

Hansen

Wichtig mit Tests die alte Welt auf zumachen.

In die Zukunft schauen, wie wir es haben wollen.

Jetzt muss es mal richtig gemacht werden.

Riesenbereich.

Wagner

Vorzug GI Gutachten vers. Fairness-Kriterien.

Wie schwer es ist verschiedene Fairness-Kriterien einzuhalten. Trade-Offs.

Vorzug von Algos, dies erstmal diskutieren zu können. Bei menschlichen Scoring

ist dies schwieriger.

Borges

Muss der Auftakt zur Auseinandersetzung sein.

Fairness ist kein Rechtsbegriff.

Dies kann man nicht am Wochenende erledigen.

Aufgabe der Politik, diesen Rahmen zu geben.

Dies strukturell zu erforschen.

Mit der AI haben wir die Möglichkeit hier tiefer reinzugehen.

Was sind legitime, was sind illegitime Vorgänge.

Allg. Algo-Gesetz wär ein Unsinn.

Zuerst verstehen, was die Probleme sind.

Strukturiertes Forschungsprogramm.

Wagner

“zum testing brauchen Sie ja nicht das Modell”

Grabmair

“die Unternehmer bisschen ins Boot zu holen”

Hansen

“zur Frage haben wir Zeit, … wir sind nicht bei Null,

wollen was zusammenbringen … wären wir noch am Anfang

Anwendung, Transparenz, Qualität … im Autobereich …

wird sich auf die STVO auswirken, sektorspezifisch ist man dran …

Lifecylce der Daten, Rechtsschutz … spamfilter … wie funktioniert der …

täglich in den Folder reingucken …

- Handlungsempfehlung

Digitalagentur

Wagner

Bundesinstitut für Algos. Kompetenzzentrum

Nicht eine Agentur alleine.

Moderator “~eher suboptimal, dass die Wirtschaft selbst die Gutachten in Auftrag geben.”

Hansen - Froh das was da ist, Gesetz ist nicht spezifisch genug.

Einzige Informatikerin.

Kulturproblem in den Behörden. Rechte und Freiheite … mit DSVGO

Wie soll ein Datenschutzbeauftragte Diskriminierung erkennen? Manche haben null Techniker, leihen sich diese vom Ministerium

Kann mir vorstellen … Prüfteams …

Bundesinstitut gut.

Grabmair

Fair lending reinschauen

Borges

Eine Kompetenzstelle aufbauen.

Seit wann BSI Aufsichtsbehörde ist, 2015, davor 4 Jahrzehnte ohne, aber mit Fachwissen.

- Kompetenz

- Testen

- Bussgeld verhängen, in 5 Jahre oder so

Kompetenz, Normen aufbauen.

me … Datenqualität

Pauli von VZBV

BGH Entscheidung “Warum bin ich unterdurchschnittlich bewertet worden?”

Wagner

Was die SCHUFA liefert muss man zwei Studienabschlüsse liefern.

Deswegen Transparenz und Verständlichkeit

Hansen

“Wegen Datenqualität hat sich noch nicht gelohnt.

Incentives. Durch Sanktionen.

BGH 1995 …

heisst nicht, dass die Karten nicht neu gemischt werden müssen.

Martini wird zitiert, Entscheidungsstrukturen.

Borges will keine Information wie der Score zusammenkommt.

(Anmerkung Analogie: Keine Auskunft über die Geschwindigkeitsbegrenzungen haben will, und immer gerne den Strafzettel gerne zahlt, weil eh …)

“Nicht nur in der Wissenschaft, auch in der Öffentlichkeit wird die Transparenz von Scoring-Verfahren diskutiert. Im Februar 2018 starteten die gemeinnützigen Organisationen Open Knowledge Foundation und Algorithm-Watch die Initiative OpenSCHUFA. Zu den erklärten Zielen des Projektes gehört es, den Algorithmus zu „knacken“, mit dem die Schufa ihre Bonitäts-scores ermittelt (OpenSCHUFA, 2018). Sowohl die in die Berechnung des Score-Wertes eingehenden Daten als auch das Verfahren, nach dem aus diesem Datenmaterial ein individueller Score ermittelt wird, will die Initiative herausfinden, indem möglichst viele Personen der Initiative ihren Schufa-Score (den sie dort erfragen) und ihre persönlichen Merkmale mitteilen. Zahlreiche Medien berichteten über das Anliegen der Initiative (exemplarisch Erdmann, 2018; Schneider, 2018), die SCHUFA selbst trat ihr kritisch entgegen (SCHUFA Holding AG, 2018)"

GI Studie

Wir verweisen auf die sieben Prinzipien des ACM (p 123 GI Studie)

Prinzipien für algorithmische Transparenz und Verantwortlichkeit sind folgende:

-

Awareness: Eigentümer, Designer, Benutzer und andere Beteiligte von Analysesystemen sollten sich der möglichen Vorurteile bewusst sein, die mit ihrer Gestaltung, Implementierung und Verwendung sowie dem möglichen Schaden, den Voreingenommenheit Einzelpersonen und der Gesellschaft verursachen kann, verbunden sind.

-

Zugang und Rechtsbehelfe: Die Regulierungsbehörden sollten die Einführung von Mechanismen fördern, die Befragungen und Rechtsbehelfe für Einzelpersonen und Gruppen ermöglichen, die von algorithmisch fundierten Entscheidungen betroffen sind.

-

Rechenschaftspflicht: Institutionen sollten für Entscheidungen verantwortlich gemacht werden, die durch die von ihnen verwendeten Algorithmen getroffen werden, auch wenn es nicht möglich ist, im Detail zu erklären, wie die Algorithmen ihre Ergebnisse produzieren.

-

Erläuterung: Systeme und Institutionen, die algorithmische Entscheidungen treffen, werden ermutigt, Erläuterungen sowohl zu den vom Algorithmus verfolgten Verfahren als auch zu den spezifischen getroffenen Entscheidungen zu geben. Dies ist besonders wichtig in öffentlichen politischen Kontexten.

-

Datenprovenienz: Eine Beschreibung der Art und Weise, in der die Trainingsdaten gesammelt wurden, sollte von den Erstellern der Algorithmen beibehalten werden, begleitet von einer Untersuchung der möglichen Verzerrungen, die durch den menschlichen oder algorithmischen Datenerfassungsprozess induziert werden. Die öffentliche Überprüfung der Daten bietet maximale Möglichkeiten für Korrekturen. Bedenken hinsichtlich des Datenschutzes, des Schutzes von Geschäftsgeheimnissen oder der Offenlegung von Analysen, die böswilligen Akteuren erlauben könnten, das System zu manipulieren, können jedoch den Zugang auf qualifizierte und autorisierte Personen einschränken.

-

Überprüfbarkeit: Modelle, Algorithmen, Daten und Entscheidungen sollten aufgezeichnet werden, damit sie in Fällen, in denen ein Schaden vermutet wird, überprüft werden können.

-

Validierung und Testen: Institutionen sollten strenge Methoden anwenden, um ihre Modelle zu validieren und diese Methoden und Ergebnisse zu dokumentieren. Insbesondere sollten sie routinemäßig Tests durchführen, um zu beurteilen und festzustellen, ob das Modell diskriminierende Schäden verursacht. Die Institutionen werden ermutigt, die Ergebnisse solcher Tests öffentlich zu machen.

Wie geht es weiter bei OpenSCHUFA?

Am 21. November werden wir in einer Podiumsdiskussion bei Wikimedia das weitere Vorgehen diskutieren. Infos folgen!

Weitere Links:

Bericht vom Tagesspiegel

Der erwähnte ProPublica Klassiker

upcoming netzpolitik

Transparenzschnittstelle FAZ

Mitglieder der Datenethikkommission

der Bundesregierung